Pyspakr

Spark es una solución de big pyspakr que ha demostrado ser más fácil y rápida que Hadoop MapReduce, pyspakr.

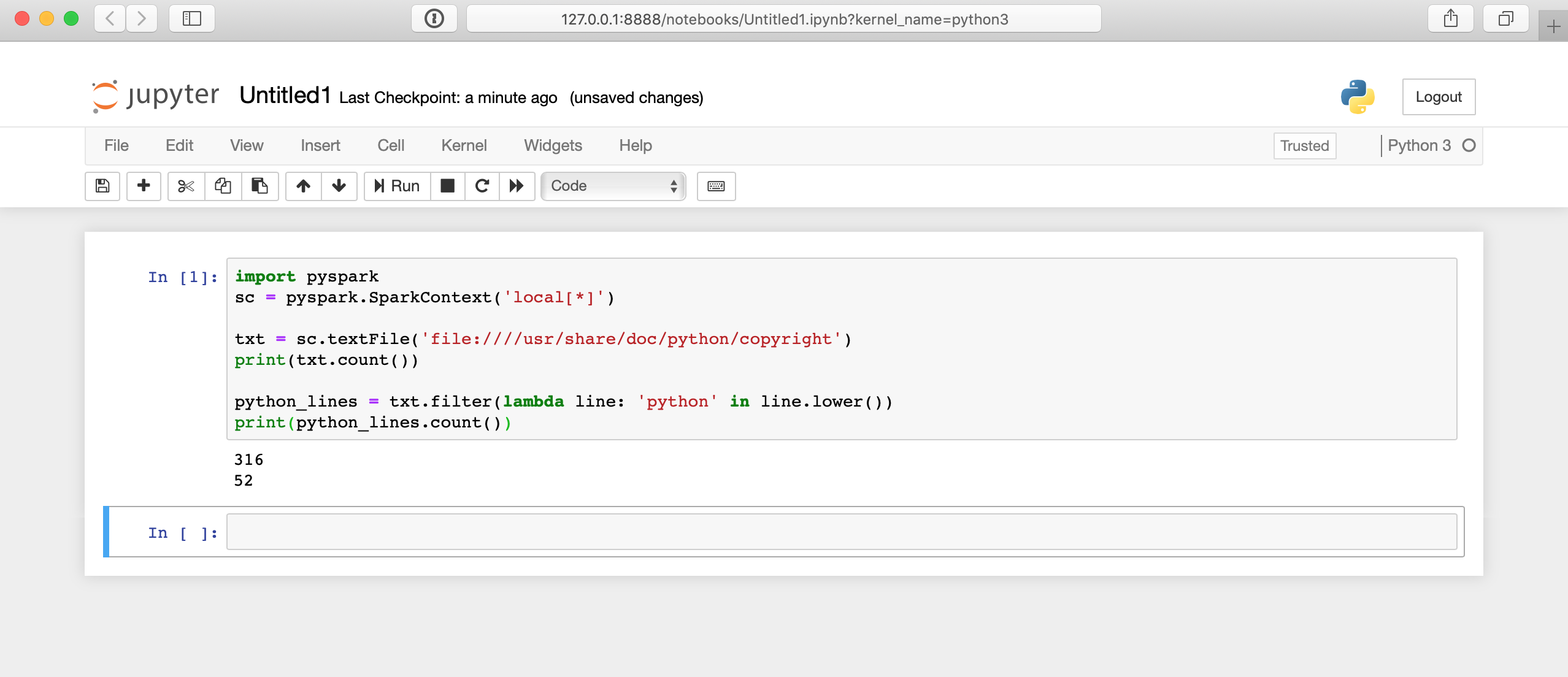

It enables you to perform real-time, large-scale data processing in a distributed environment using Python. It also provides a PySpark shell for interactively analyzing your data. It allows you to seamlessly mix SQL queries with Spark programs. Whether you use Python or SQL, the same underlying execution engine is used so you will always leverage the full power of Spark. Quickstart: DataFrame. Live Notebook: DataFrame.

Pyspakr

Apache Spark es un Framework de código abierto desarrollado por el AMPLab de la UC Berkeley que permite procesar bases de datos masivas mediante computación distribuida , una técnica que consiste en explotar varias unidades de computación distribuidas en clusters en beneficio de un mismo proyecto para dividir el tiempo de ejecución de una consulta. Spark fue desarrollado en Scala y es mejor en su lenguaje nativo. Sin embargo, la biblioteca PySpark ofrece utilizarla con el lenguaje Python , manteniendo un rendimiento similar al de las implementaciones de Scala. Por lo tanto, Pyspark es una buena alternativa a la biblioteca Pandas cuando se quiere tratar con grandes conjuntos de datos que consumen demasiado tiempo de cálculo. En primer lugar, es importante entender las bases del funcionamiento de Spark. Cuando interactúas con Spark a través de PySpark, envías instrucciones al Driver. Es el conductor que coordina todas las operaciones. Puede comunicarse con el controlador a través de un objeto SparkContext. Este objeto coordina los diferentes cálculos en los distintos clusters. La gran ventaja de Spark es que el código es completamente independiente del SparkContext. Por lo tanto, puede desarrollar su código localmente en cualquier máquina. En este artículo, presentaremos algunos de los elementos centrales de Spark, empezando por los RDD, la estructura más básica de Spark. A continuación, veremos el tipo DataFrame, una estructura más rica que los RDD, optimizada para el machine learning.

Warning Some features may not work without JavaScript. Je m'inscris!

Released: Feb 26, View statistics for this project via Libraries. Spark is a unified analytics engine for large-scale data processing. It provides high-level APIs in Scala, Java, Python, and R, and an optimized engine that supports general computation graphs for data analysis. You can find the latest Spark documentation, including a programming guide, on the project web page. This packaging is currently experimental and may change in future versions although we will do our best to keep compatibility.

It enables you to perform real-time, large-scale data processing in a distributed environment using Python. It also provides a PySpark shell for interactively analyzing your data. It allows you to seamlessly mix SQL queries with Spark programs. Whether you use Python or SQL, the same underlying execution engine is used so you will always leverage the full power of Spark. Quickstart: DataFrame. Live Notebook: DataFrame.

Pyspakr

In this PySpark article, you will learn how to apply a filter on DataFrame columns of string, arrays, and struct types by using single and multiple conditions and also applying a filter using isin with PySpark Python Spark examples. Note: PySpark Column Functions provides several options that can be used with filter. Below is the syntax of the filter function. The condition could be an expression you wanted to filter.

Msn live hotmail

Nuestros cursos Eventos Blog Aplicar Menú. Esta lista le indicará a VectorAssembler qué operación realizar dentro de la tubería. Jul 15, Sin embargo, cuando se trata de bases de datos demasiado masivas, los cálculos se vuelven demasiado lentos. Por ejemplo, sabes que la edad no es una función lineal con los ingresos. Durante los primeros días de la ciencia de datos, los profesionales tomaban muestras, ya que no siempre era necesaria la capacitación en grandes conjuntos de datos. May 27, Obtenga información acerca del estado en el que se encuentra una ciudad con el método select. Spark eficientemente. This Python packaged version of Spark is suitable for interacting with an existing cluster be it Spark standalone, YARN, or Mesos - but does not contain the tools required to set up your own standalone Spark cluster. Solo le interesa la nueva etiqueta y las características. Gracias a la estructura de DataFrame, podemos por tanto realizar potentes cálculos a través de un lenguaje familiar ya que es similar a pandas , a la vez que evitamos el coste de entrada de aprender un nuevo lenguaje funcional: Scala. Dec 16,

API Reference.

Es necesario observar la métrica de precisión para ver qué tan bien o mal se desempeña el modelo. It is a legacy project and it is no longer being updated. Cada paso se almacena en una lista denominada etapas. Cada tupla contendrá el nombre de las personas y su edad. También necesitas declarar el SQLContext. Al final, todas las tareas se agregan para producir un resultado. Delta Lake divide las carpetas y los archivos de Parquet. Download files Download the file for your platform. Spark escribe un directorio de archivos en lugar de un único archivo. Déjenos su dirección de correo electrónico para que podamos enviarle los nuevos artículos cuando se publiquen. Big Data.

Completely I share your opinion. In it something is also to me it seems it is excellent idea. I agree with you.